第四届网络生态治理论坛:大模型的价值观与安全对齐

对齐技术主要解决让大模型在后训练阶段满足有用、诚实、无害的要求。基于人类反馈的强化学习RLHF被证明是一种有效的对齐语言模型的方法。

以ChatGPT为代表的大模型飞速发展,正在成为驱动新质生产力发展的新动能、人类探索未知的新工具。在显著提升AI模型通用理解和生成能力的同时,也带来了前所未有的安全风险。论坛将围绕大模型安全主题,讨论大模型价值观及其对齐技术的现状、挑战和发展趋势、探讨如何促使大模型更好地遵循人类价值观、服从人类意图、规避各类风险。

2024年,第四届网络生态治理论坛聚焦大模型价值观和安全对齐,非常荣幸地邀请到来自清华大学、北京大学、哈尔滨工业大学、复旦大学等研发团队一线专家和学者,将从心理学、计算机科学等学科角度切入,就大模型价值观及其安全对齐分享精彩的报告。并邀请产业界网络安全专家,在Panel环节开展产学两届深度对话。

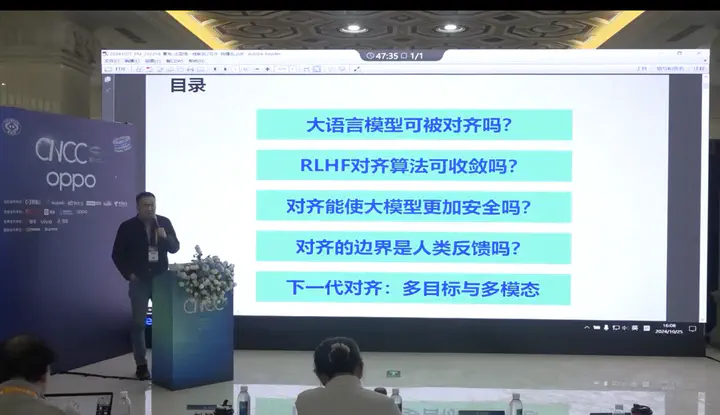

在本讲中,杨耀东介绍了RLHF方法的挑战,并阐述了在安全对齐、价值对齐、超级对齐上的一些新方法,新思考。